Y A L’IA !

![]()

Le domaine de l’intelligence artificielle (IA) a connu une croissance exponentielle ces dernières années, avec des investissements massifs de la part de grandes entreprises devenues transnationales, telles que Google, IBM, Microsoft, Amazon, Facebook, Apple, Baidu, Intel, NVIDIA, Tesla, DeepMind et OpenAI, pour n’en nommer que quelques-unes parmi les acteurs majeurs (Russel et Norvig, 2022). Cette expansion rapide s’explique par des progrès significatifs dans divers domaines d’ingénieries avancées.

Tout d’abord, des améliorations ont été réalisées dans la puissance de calcul et la miniaturisation des volumes de stockage, ouvrant ainsi de nouvelles perspectives dans le domaine de l’apprentissage automatique des machines. Les progrès technologiques ont permis de développer des processeurs plus puissants, des architectures de calcul parallèle et des techniques d’optimisation des algorithmes, ce qui a considérablement accéléré les calculs nécessaires pour l’entraînement et l’exécution des modèles d’IA (LeCun et al., 2015). En même temps, la miniaturisation des dispositifs de stockage, tels que les disques durs et les cartes mémoire, a permis de stocker et de manipuler des ensembles de données massifs de manière plus pratique et efficace (Dean et al., 2012). Ces avancées ont ouvert la voie à des applications pratiques de l’IA dans de nombreux domaines. Par exemple, dans le domaine de la reconnaissance d’images, des réseaux de neurones profonds peuvent être entraînés sur d’énormes ensembles de données d’images afin de reconnaître et de classifier automatiquement des objets, des visages ou des scènes (Krizhevsky et al., 2012). Autre exemple, dans le domaine de la traduction automatique, où les IA peuvent analyser et comprendre des textes dans une langue source pour les traduire avec précision dans la langue souhaitée (Sutskever et al., 2014). La malédiction longtemps associée à la construction de la Tour de Babel serait-elle en passe d’être brisée ?

Parmi les autres progrès de ces dernières années, mettons en lumière l’effort de recherche et développement (R&D) consenti pour l’amélioration des agrégateurs de données dans l’économie numérique. Les entreprises ayant moissonné d’énormes quantités d’informations les exploitent désormais pour coder de nouveaux modèles algorithmiques. Ceux-ci ont pour but affiché d’œuvrer dans l’amélioration de produits, de services ou même de processus commerciaux, en permettant notamment la publicité ciblée, l’assistance intelligente ou encore le déploiement de services après-vente moins coûteux (Davenport et al., 2012). Nous avons tous en tête que depuis ses débuts en 1998 Google utilise les informations liées aux requêtes des internautes pour optimiser son moteur de recherche. Depuis cette date, l’entreprise collecte et analyse les données de recherche afin d’améliorer son algorithme dans le but d’offrir des résultats plus précis et de mieux comprendre les intentions des utilisateurs dans leur quête d’information (Dean et al., 2008). Mais Google ne s’est pas limité à ce service : il a également commencé à utiliser les données de recherche pour afficher des publicités et des annonces dites ciblées en se référant à nos requêtes passées. Cela a soulevé des préoccupations quant aux bulles de filtre et à la protection des données personnelles. Les experts en protection des données et en éthique de l’IA soulignent l’importance de politiques de protection des données et de mécanismes de consentement éclairé pour garantir le respect des droits des individus (Nissenbaum, 2010; Mayer-Schönberger et Cukier, 2013).

Parmi les autres progrès de ces dernières années, mettons en lumière l’effort de recherche et développement (R&D) consenti pour l’amélioration des agrégateurs de données dans l’économie numérique. Les entreprises ayant moissonné d’énormes quantités d’informations les exploitent désormais pour coder de nouveaux modèles algorithmiques. Ceux-ci ont pour but affiché d’œuvrer dans l’amélioration de produits, de services ou même de processus commerciaux, en permettant notamment la publicité ciblée, l’assistance intelligente ou encore le déploiement de services après-vente moins coûteux (Davenport et al., 2012). Nous avons tous en tête que depuis ses débuts en 1998 Google utilise les informations liées aux requêtes des internautes pour optimiser son moteur de recherche. Depuis cette date, l’entreprise collecte et analyse les données de recherche afin d’améliorer son algorithme dans le but d’offrir des résultats plus précis et de mieux comprendre les intentions des utilisateurs dans leur quête d’information (Dean et al., 2008). Mais Google ne s’est pas limité à ce service : il a également commencé à utiliser les données de recherche pour afficher des publicités et des annonces dites ciblées en se référant à nos requêtes passées. Cela a soulevé des préoccupations quant aux bulles de filtre et à la protection des données personnelles. Les experts en protection des données et en éthique de l’IA soulignent l’importance de politiques de protection des données et de mécanismes de consentement éclairé pour garantir le respect des droits des individus (Nissenbaum, 2010; Mayer-Schönberger et Cukier, 2013).

Pour terminer ce tour d’horizon des progrès fascinants de cette dernière décennie, soulignons les efforts considérables déployés dans le domaine de l’analyse de données en temps réel, qui permettent aux systèmes d’IA de traiter des quantités massives de données provenant de diverses sources. Les spécialistes du secteur mettent en place des pipelines de traitement et utilisent des algorithmes d’apprentissage automatique conçus pour analyser les données « instantanément » (Chen et al., 2018). Ces systèmes d’IA peuvent être configurés pour détecter les tendances du marché, prédire les comportements des clients et repérer des anomalies ou des événements pertinents en analysant en temps réel les flux de données provenant des plateformes de médias sociaux (Bifet et al., 2018). Cependant, il convient de souligner que les décisions prises uniquement sur la base de données en temps réel comportent des risques potentiels, tels que la concentration sur des informations superficielles ou la présence de biais cognitifs (Pasquale, 2015). De plus, la précision des prédictions en temps réel peut être compromise si les modèles d’IA ne sont pas correctement formés ou si les données utilisées sont bruitées ou inexactes, voire soumises à du « poisoning » technique visant à corrompre les données utilisées dans les modèles d’IA (Biggio et al., 2018). Cela souligne la nécessité d’une validation rigoureuse des données, de la calibration des modèles et d’une surveillance continue pour minimiser les risques et assurer la fiabilité des résultats obtenus (Carlini et al., 2018).

Ces avancées passionnantes dans le domaine de l’intelligence artificielle offrent des possibilités prometteuses mais soulèvent également des questions éthiques et des défis en matière de protection des données. Les chercheurs, ingénieurs et philosophes s’engagent dans des travaux approfondis pour aborder ces problématiques complexes et garantir que l’IA soit développée et utilisée de manière responsable et respectueuse des droits individuels. Très bien mais pendant ce temps…

L’ARRIVÉE DU GRAND CHAMBOULE-TOUT

Passons en revue les multiples domaines d’activités qui ont été profondément impactés par l’évolution des moyens que nous avons vu précédemment. L’IA a révolutionné de nombreux secteurs en offrant des opportunités nouvelles et des avancées technologiques que l’on pourrait qualifier de « significatives ». De la santé à la finance, en passant par les transports, la justice et les pratiques artistiques, l’IA a ouvert de nouvelles perspectives, améliorant les processus existants, optimisant les performances et créant de nouvelles solutions. Cette technologie prometteuse a transformé la manière dont nous interagissons avec les machines et a ouvert la voie à tout un panel de nouvelles pratiques. Examinons en détail comment l’IA a façonné ces domaines clés et quelles en sont les implications, les bénéfices ainsi que les préoccupations éthiques à avoir en vue.

Dans le domaine de la logistique, les systèmes d'IA sont principalement utilisés pour automatiser l'optimisation des itinéraires de livraison. Ils analysent les conditions de circulation en temps réel, les données météorologiques et d'autres variables pertinentes pour déterminer les itinéraires les plus efficaces pour les véhicules de livraison. Cette automatisation permet de réduire les temps de trajet, d'optimiser l'utilisation des ressources et d'améliorer la satisfaction des clients. Des entreprises comme UPS utilisent l'IA pour optimiser leurs itinéraires et économiser des millions de dollars chaque année en frais de carburant et d'usure de véhicule.

Néanmoins, certains experts soulèvent des préoccupations quant à la dépendance excessive à l'égard des systèmes d'IA dans la logistique. Bien que ces systèmes puissent apporter des avantages significatifs, ils ne doivent pas être considérés comme une solution infaillible. Les erreurs de prédiction ou de traitement des données peuvent avoir un impact direct sur la performance des itinéraires de livraison, entraînant des retards ou des problèmes logistiques. Des études comme celle menée par C. Barnhart et al. ont mis en évidence les défis liés à la robustesse des modèles d'IA dans le domaine de l'optimisation des itinéraires. Par ailleurs, l'automatisation de l'optimisation des itinéraires peut également avoir des implications sociales et environnementales. Lorsque les systèmes d'IA se concentrent uniquement sur l'efficacité et la réduction des coûts, ils peuvent négliger d'autres facteurs importants tels que l'impact environnemental, les conditions de travail des chauffeurs ou les besoins spécifiques des clients. Il est donc crucial de trouver un juste équilibre entre l'efficacité opérationnelle et les considérations sociales et environnementales dans l'utilisation des systèmes d'IA.

En outre, l'adoption généralisée de systèmes d'IA dans la logistique soulève des questions liées à la sécurité et à la confidentialité des données. Les systèmes d'IA traitent une grande quantité de données sensibles, telles que les informations sur les clients, les horaires de livraison et les emplacements des véhicules. Il est donc essentiel de mettre en place des mesures de sécurité solides pour protéger ces données contre les cyberattaques et les violations de la vie privée. Des recherches menées par S. Zhao et al. ont mis en évidence l'importance de l'intégration de mécanismes de sécurité dans les systèmes d'IA pour garantir la confidentialité et l'intégrité des données.

Dans un contexte plus large, l'automatisation croissante dans le secteur de la logistique peut également avoir des conséquences sur l'emploi. En effet, les systèmes d'IA et les technologies automatisées améliorent l'efficacité, mais peuvent également réduire la demande de main-d'œuvre humaine, ce qui peut entraîner des pertes d'emplois dans certains domaines. Des travaux comme ceux menés par M. Osborne et C. Frey ont examiné l'impact de l'automatisation sur l'emploi dans différents secteurs, y compris la logistique, et ont souligné la nécessité de prendre des mesures pour anticiper ces changements et assurer une transition juste vers une logistique largement automatisée.

Face à ces défis, il est essentiel que les chercheurs, les ingénieurs et les décideurs s'engagent dans des travaux approfondis pour aborder les questions éthiques et les défis liés à l'IA dans le domaine de la logistique. Des initiatives telles que le Responsible AI for Logistics (RAIL) consortium ont été créées pour promouvoir le développement et l'utilisation responsables de l'IA dans le secteur logistique, en mettant l'accent sur des principes tels que la transparence, la responsabilité et l'équité. Les efforts sont également en cours pour développer des normes et des réglementations qui encadrent l'utilisation de l'IA dans la logistique et garantissent la protection des données et des droits individuels.

En conclusion, les avancées passionnantes dans le domaine de l'intelligence artificielle offrent des possibilités prometteuses dans la logistique, notamment en automatisant l'optimisation des itinéraires de livraison. Cependant, ces avancées soulèvent également des questions éthiques, des défis en matière de protection des données et des implications sur l'emploi. Il est essentiel que les acteurs concernés s'engagent dans des travaux approfondis pour aborder ces problématiques complexes et veiller à ce que l'IA soit développée et utilisée de manière responsable, respectueuse des droits individuels et en équilibre avec les considérations sociales et environnementales.

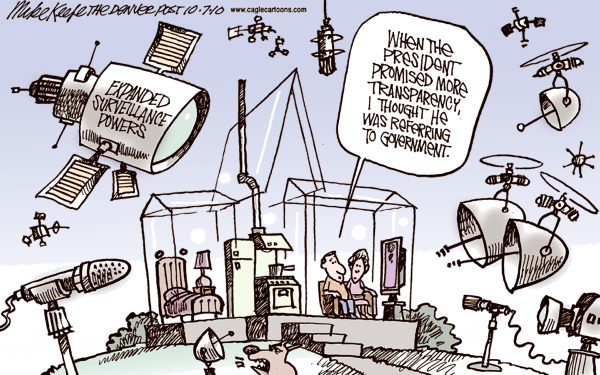

Dans le domaine de la surveillance et de la sécurité, l'IA joue un rôle clé dans la détection et la prévention des activités criminelles. Les systèmes de vidéosurveillance équipés de capacités d'IA peuvent détecter les comportements suspects, les intrusions ou les activités illicites, renforçant ainsi la sécurité des lieux publics et privés. Par exemple, la startup londonienne Vivacity Labs a utilisé des caméras intelligentes alimentées par l'IA pour surveiller et analyser le trafic routier, contribuant ainsi à l'amélioration de la sécurité et de la gestion du trafic.

Cependant, l'utilisation généralisée de la surveillance basée sur l'IA soulève des préoccupations majeures en matière de respect de la vie privée et de surveillance de masse. Les systèmes de vidéosurveillance alimentés par l'IA peuvent collecter et analyser d'énormes quantités de données, ce qui suscite des inquiétudes quant à l'utilisation abusive ou excessive de ces informations. Il est crucial de trouver un équilibre entre la sécurité publique et la protection de la vie privée des individus, en garantissant que les mesures de surveillance sont justifiées, proportionnées et conformes aux lois et réglementations en vigueur.

Une autre critique fréquente concerne les biais et les erreurs potentiels des systèmes d'IA utilisés dans la surveillance. Les algorithmes d'IA sont formés sur la base de données existantes, et si ces données sont biaisées ou non représentatives, cela peut entraîner des prédictions erronées ou des décisions discriminatoires. Les systèmes de reconnaissance faciale basés sur l'IA, par exemple, ont été critiqués pour leur tendance à identifier de manière disproportionnée les personnes de certaines origines ethniques ou les femmes. Il est donc essentiel que les législateurs veillent à ce que les systèmes d'IA utilisés dans la surveillance soient éthiques, équitables et régulièrement évalués pour détecter et corriger les biais potentiels.

Enfin, l'automatisation croissante de la surveillance peut également soulever des préoccupations concernant la perte de contrôle humain sur les décisions algorithmiques. Alors que les systèmes d'IA deviennent de plus en plus autonomes, il est important de mettre en place des mécanismes de contrôle et de transparence pour garantir que les décisions prises par ces systèmes sont compréhensibles, explicables et soumises à une supervision humaine adéquate .

Dans l'ensemble, l'utilisation de l'IA dans la surveillance et la sécurité présente à la fois des avantages et des défis. Il est essentiel de prendre en compte les préoccupations éthiques, la protection de la vie privée, la prévention des biais et la préservation du contrôle humain afin de garantir que ces technologies sont déployées de manière responsable et respectueuse des droits individuels.

Dans le domaine de la cybersécurité, l'IA aide depuis de nombreuses années les services de renseignements dans la détection des menaces et des attaques informatiques. Les systèmes d'IA analysent les modèles de trafic réseau pour identifier les comportements suspects, repérer les tentatives de piratage et détecter les comportements malveillants dans les données du réseau. Par exemple, Darktrace utilise des algorithmes d'IA pour détecter les anomalies dans le trafic réseau et prévenir les cyberattaques .

Cependant, l'utilisation de l'IA en cybersécurité n'est pas sans critiques. Tout d'abord, les adversaires malveillants peuvent également exploiter l'IA pour concevoir des attaques sophistiquées. Les cybercriminels peuvent utiliser des techniques d'apprentissage automatique pour améliorer l'efficacité de leurs attaques et contourner les systèmes de défense basés sur l'IA. Cela nécessite une constante évolution des méthodes de cybersécurité pour contrer les attaques avancées et les techniques d'obfuscation utilisées par les cybercriminels . De plus, les systèmes d'IA en cybersécurité sont également sujets à des faux positifs et des faux négatifs. Les faux positifs se produisent lorsque le système d'IA identifie à tort une activité normale comme étant une menace, ce qui peut entraîner une surcharge de travail pour les équipes de sécurité et des répercussions négatives sur les opérations régulières de l'organisation. Les faux négatifs, quant à eux, se produisent lorsque le système d'IA ne parvient pas à détecter une véritable menace, ce qui expose l'organisation à des dangers. Il est essentiel d'affiner constamment les algorithmes d'IA pour réduire les faux positifs et les faux négatifs, tout en maintenant un équilibre entre la détection précise des menaces et la minimisation des interruptions inutiles .

L'IA est aussi utilisée pour développer des systèmes de détection d'intrusion avancés (IDS) et des systèmes de prévention d'intrusion (IPS). Ces systèmes utilisent des techniques d'apprentissage automatique pour analyser les journaux d'événements, les signatures de logiciels malveillants et les schémas d'attaque connus afin d'identifier les comportements suspects et de bloquer les activités malveillantes. Des entreprises comme Cisco et FireEye proposent des solutions de sécurité basées sur l'IA pour protéger les réseaux et les systèmes contre les cybermenaces , .

Pour autant, l'utilisation généralisée de la surveillance basée sur l'IA soulève des préoccupations majeures en matière de respect de la vie privée et de surveillance de masse . Les systèmes de vidéosurveillance alimentés par l'IA peuvent collecter et analyser d'énormes quantités de données, ce qui suscite des inquiétudes quant à l'utilisation abusive ou excessive de ces informations, mais aussi l'impact écologique d'un tel projet . Il est important de trouver un équilibre entre la sécurité publique et la protection de la vie privée des individus, en veillant à ce que les mesures de surveillance soient justifiées, proportionnées et conformes aux lois et réglementations en vigueur . Mais il faut aussi avoir le courage de nous interroger sur la pertinence d'installer tel système de surveillance pour assurer une sécurité toute relative. Une autre critique fréquente est que les systèmes d'IA utilisés dans la surveillance peuvent être sujets à des biais et des erreurs. Les algorithmes d'IA sont formés sur la base de données existantes, et si ces données sont biaisées ou non représentatives, voire même filtrées ou occultées, cela peut entraîner des prédictions erronées ou des décisions discriminatoires. Par exemple, les systèmes de reconnaissance faciale basés sur l'IA ont été critiqués pour leur tendance à identifier de manière disproportionnée les personnes de certaines origines ethniques, et même carrément les femmes . Il est donc crucial de nous assurer que les systèmes d'IA lorsqu'ils sont utilisés dans la surveillance soient éthiques, équitables et régulièrement évalués pour détecter et corriger les biais potentiels . Il est donc essentiel de garantir qu'ils restent soumis à une supervision humaine adéquate afin de prévenir la perte de contrôle et la prise de décisions algorithmiques autonomes. Pour s'en assurer, des chercheurs ont démontré que les systèmes d'IA peuvent être trompés et induits en erreur, ce qui pourrait avoir des conséquences graves . Par exemple, des attaquants pourraient utiliser des techniques de "poisoning" ou d'altération de données pour perturber l'IA et la tromper en lui faisant prendre de mauvaises décisions. Enfin, cette complexité de la technologie peut également rendre leur compréhension et leur auditabilité très difficiles, et finalement accessible qu'à une toute petite poignée d'individus détenant dès lors un pouvoir considérable .

L'IA est devenue omniprésente dans le domaine de la médecine, permettant le développement de systèmes de diagnostic et d'aide à la décision médicale. Ces systèmes offrent des avantages considérables tels qu'une précision accrue et des délais plus courts dans les procédures médicales. Les algorithmes d'apprentissage automatique analysent de vastes ensembles de données médicales, notamment des images médicales et des dossiers médicaux électroniques, afin d'aider à détecter les maladies, à identifier les traitements optimaux et à prédire les résultats des patients. Des entreprises pionnières dans ce domaine, comme PathAI, se consacrent activement à l'utilisation de l'IA pour améliorer le diagnostic et le traitement du cancer .

Cependant, l'utilisation de l'IA en médecine soulève également des préoccupations et des critiques. L'une des préoccupations majeures concerne la fiabilité et la validité des systèmes d'IA utilisés dans le domaine médical. Bien que l'IA puisse fournir des résultats précis, il est important de noter qu'elle repose sur des modèles et des algorithmes basés sur des données préalablement collectées. Par conséquent, si les données utilisées sont biaisées ou incomplètes, cela peut entraîner des résultats incohérents ou des erreurs de diagnostic . Il est donc essentiel d'accorder une attention particulière à la qualité des données utilisées pour l'entraînement des systèmes d'IA afin de garantir leur fiabilité et leur efficacité dans la pratique médicale.

Une autre critique majeure concerne la dépendance excessive à l'égard des systèmes d'IA et le risque de déshumanisation des soins de santé. Bien que l'IA puisse fournir des informations précieuses et faciliter les décisions médicales, elle ne peut pas remplacer le rôle crucial des professionnels de la santé dans la prise en charge globale des patients. Il est essentiel de maintenir une approche équilibrée en intégrant l'IA comme un outil complémentaire aux compétences et à l'expertise des médecins et des infirmières, afin de garantir une approche holistique et centrée sur le patient. De plus, la confidentialité et la sécurité des données de santé sont des préoccupations majeures liées à l'utilisation de l'IA en médecine. Les systèmes d'IA nécessitent un accès à des données médicales sensibles, ce qui soulève des questions quant à la protection de la vie privée des patients. Il est essentiel de mettre en place des mesures robustes de protection des données, telles que le chiffrement et les protocoles de sécurité avancés, pour prévenir les violations de la vie privée et garantir la confidentialité des informations médicales .

Enfin, l'adoption généralisée de l'IA en médecine soulève des préoccupations éthiques importantes, notamment en ce qui concerne l'équité et l'accès aux soins. L'utilisation de l'IA peut intensifier les disparités existantes en matière de santé, en particulier pour les populations marginalisées ou mal desservies. Il est primordial de veiller à ce que les bénéfices de l'IA en médecine soient équitablement répartis et ne renforcent pas les inégalités. Cela nécessite une attention particulière pour éviter les biais dans les données utilisées pour entraîner les systèmes d'IA et pour s'assurer que ces systèmes sont adaptés à diverses populations . De plus, l'intégration de l'IA dans les pratiques de soins de santé peut soulever des questions quant à la responsabilité et à la responsabilisation. En cas d'erreur ou de résultat indésirable, il peut être difficile de déterminer la responsabilité, en particulier lorsque les décisions sont prises par des algorithmes complexes. Il est crucial d'établir des cadres réglementaires et juridiques appropriés pour définir les responsabilités et les obligations liées à l'utilisation de l'IA en médecine, afin de protéger les droits et la sécurité des patients.

Là où l'essor de l'IA a été le plus significatif et le plus visible est indéniablement dans le développement des véhicules dits autonomes, chez Tesla et Waymo, filiale de Google. Ces voitures utilisent des systèmes d'IA embarqués pour percevoir leur environnement, prendre des décisions en temps réel et interagir avec les autres véhicules et les piétons. Grâce à l'apprentissage automatique et à la cartographie avancée, les véhicules peuvent désormais naviguer de manière totalement autonome . Selon les ingénieurs et concepteurs, cela pourrait même permettre de réduire les risques d'accidents, d'améliorer l'efficacité du trafic et d'offrir une mobilité plus sûre et plus accessible.

Cependant, leur intégration soulève également des critiques et des défis importants. L'une des principales préoccupations concerne la sécurité. Bien que les systèmes d'IA soient conçus pour prendre des décisions basées sur des algorithmes préétablis, il subsiste une incertitude quant à la manière dont ils réagiront dans toutes les situations possibles sur la route. Des questions se posent également sur la responsabilité en cas d'accident impliquant un véhicule autonome. Qui serait tenu pour responsable : le fabricant du véhicule, le propriétaire, le conducteur (s'il y en a un), ou le système d'IA lui-même ? Cette question complexe nécessite des discussions approfondies sur le plan juridique et réglementaire.

Un autre aspect critique est la protection de la vie privée et l'infalsifiabilité des données. Les véhicules autonomes génèrent une énorme quantité de données, notamment des informations sur les déplacements, les préférences des utilisateurs et même des données sensibles provenant des capteurs embarqués. Il est donc devenu essentiel pour les ingénieurs de mettre en place des mécanismes de protection des données pour éviter toutes formes d'abus et de violations. De plus, l'adoption généralisée de véhicules autonomes pourrait avoir un impact socio-économique significatif. Bien que cela puisse révolutionner le secteur des transports en offrant une mobilité plus efficace, leur déploiement pourrait entraîner la suppression d'emplois liés à la mobilité ou à la livraison, tels que les chauffeurs de taxi et les chauffeurs de camion. Il est donc crucial de prendre en compte les implications sociales et économiques de l'introduction de l'IA dans le domaine des transports et de susciter un débat public autour de l'adoption généralisée de ces véhicules.

La détection de fraudes est un domaine dans lequel l'IA peut être particulièrement efficace. Les systèmes d'IA utilisent des algorithmes d'apprentissage automatique pour analyser les schémas, les comportements et les transactions suspects. Dans le secteur financier, par exemple, l'IA pourrait détecter les transactions frauduleuses en identifiant des modèles d'achat anormaux ou en comparant les transactions actuelles à des schémas de fraude connus. Des entreprises comme PayPal utilisent déjà l'IA pour prévenir de possibles fraudes en ligne.

Cependant, malgré les avantages indéniables de l'utilisation de l'IA dans la détection de fraudes, il est important de reconnaître ses limites et de rester critique quant à son efficacité. Certains experts soulignent que les systèmes d'IA peuvent présenter des taux élevés de faux positifs ou de faux négatifs, ce qui peut entraîner des surcoûts liés aux erreurs . De plus, les fraudeurs s'adaptent constamment et trouvent sans cesse de nouveaux moyens de contourner les algorithmes de détection, ce qui nécessite une surveillance et une mise à jour constantes des systèmes.

Il est également essentiel de prendre en compte les implications éthiques de l'utilisation de l'IA dans la détection de fraudes. Lorsque des systèmes d'IA sont utilisés pour prendre des décisions automatiques, il y a un risque de discrimination ou de stigmatisation injuste, notamment envers des groupes marginalisés. Par exemple, si les modèles d'IA sont basés sur des données historiques biaisées, ils peuvent reproduire ces biais et aboutir à des résultats injustes pouvant engendrer de nouvelles victimes. En réponse à ces préoccupations, il est nécessaire de mettre en place des mécanismes de contrôle et de réglementation pour assurer une utilisation responsable de l'IA dans la détection de fraudes. Cela implique d'examiner attentivement les données utilisées pour former les modèles d'IA, de s'assurer de la transparence des décisions prises par les algorithmes et de permettre aux individus de contester les décisions automatisées qui les concernent.

En plus de ces considérations, la détection de fraudes implique également des aspects juridiques importants. La collecte et l'utilisation de données personnelles dans le but de détecter les fraudes doivent être conformes aux lois et réglementations en matière de protection des données. Les individus doivent être informés de la manière dont leurs données sont collectées, traitées et utilisées, et doivent avoir le droit de donner leur consentement éclairé. Des études ont souligné la nécessité de mettre en place des cadres légaux solides pour encadrer l'utilisation de l'IA dans la détection de fraudes, afin de prévenir les abus et de protéger les droits des individus.

De plus, les progrès technologiques et l'utilisation croissante de l'IA dans la détection de fraudes ont conduit à une course constante entre les fraudeurs et les développeurs de systèmes de sécurité. Les fraudeurs cherchent en permanence de nouvelles techniques pour tromper les systèmes de détection, tandis que les chercheurs en sécurité travaillent à améliorer les algorithmes de détection pour contrer ces nouvelles menaces. Cela met en évidence la nécessité d'une recherche continue et d'une collaboration entre les experts en IA, les chercheurs en sécurité et les professionnels de la lutte contre la fraude pour rester en avance sur les stratégies de fraude.

La mise en œuvre de l’IA dans le domaine de la justice a suscité des changements significatifs dans la pratique judiciaire. Les systèmes d’IA sont utilisés pour analyser de vastes quantités de données juridiques, y compris des décisions de justice antérieures, des lois et des réglementations, afin de fournir des recommandations et des conseils aux professionnels du droit.

Par exemple, certains systèmes d’IA peuvent aider les avocats à rechercher des précédents juridiques, à formuler des arguments et à prédire les résultats probables d’un litige. Ces outils peuvent accélérer la recherche juridique et améliorer l’efficacité des professionnels du droit dans leur travail quotidien.

Cependant, l’utilisation de l’IA dans la pratique judiciaire soulève également des préoccupations éthiques et de responsabilité. Les décisions automatisées peuvent manquer de transparence, ce qui rend difficile la compréhension de la logique et du raisonnement derrière ces décisions. Cela soulève des questions sur la capacité des individus à contester ou à remettre en question les décisions prises par des systèmes d’IA.

De plus, il est essentiel de garantir que les systèmes d’IA utilisés dans la pratique judiciaire soient exempts de biais discriminatoires. Des études ont montré que les systèmes d’IA peuvent reproduire des biais présents dans les données sur lesquelles ils sont formés, ce qui peut entraîner des résultats injustes et discriminatoires. Il est donc crucial de collecter des données diversifiées et représentatives et de mettre en place des mécanismes de validation rigoureux pour réduire ces biais et garantir l’équité dans la prise de décision juridique.

Pour répondre à ces préoccupations, des chercheurs et des experts en IA travaillent sur le développement de modèles et d’algorithmes d’IA éthiques, qui intègrent des principes de justice, de transparence et de responsabilité. Des approches telles que l’apprentissage équitable et l’interprétabilité des modèles d’IA sont explorées pour réduire les biais et améliorer la compréhension des décisions prises par les systèmes d’IA.

L'IA joue également un rôle croissant dans les pratiques artistiques et culturelles, ainsi que dans la production artistique. Les artistes et les créateurs utilisent l'IA comme outil pour générer de nouvelles formes d'expression artistique, explorer de nouveaux médiums et repousser les limites de la créativité.

L'IA peut être utilisée pour créer des œuvres d'art, des compositions musicales, des sculptures, des films et bien plus encore. Des algorithmes d'apprentissage automatique sont entraînés sur des ensembles de données artistiques existants, leur permettant de comprendre les styles, les motifs et les techniques utilisés par les artistes . En utilisant ces connaissances, l'IA peut générer de nouvelles œuvres qui imitent ou fusionnent différents styles artistiques.

Cependant, malgré les possibilités fascinantes offertes par l'IA dans le domaine artistique, il y a aussi des critiques qui lui sont adressées. Certains estiment que l'utilisation de l'IA dans la création artistique peut réduire le rôle de l'artiste en tant qu'individu créatif. L'IA est souvent perçue comme un outil qui reproduit des modèles existants plutôt que de générer une véritable originalité artistique . Il peut y avoir un sentiment de perte d'authenticité et d'émotion dans les œuvres créées par des algorithmes.

De plus, l'IA soulève des questions sur la propriété intellectuelle et les droits d'auteur. Lorsque des œuvres sont générées par des algorithmes d'IA, il peut être difficile de déterminer qui en est réellement l'auteur et qui détient les droits sur ces œuvres. Cette question est particulièrement pertinente lorsque les œuvres d'IA sont commercialisées et vendues sur le marché de l'art.

Il est également important de prendre en compte les biais et les préjugés potentiels dans les données utilisées pour entraîner les algorithmes d'IA artistique. Si les ensembles de données sont limités ou reflètent des déséquilibres culturels, cela peut se refléter dans les œuvres générées, reproduisant ainsi des stéréotypes ou des injustices existantes . Pour atténuer ces critiques, il est essentiel d'adopter une approche réfléchie et éthique dans l'utilisation de l'IA dans la production artistique.

Les artistes doivent être conscients des implications de l'utilisation de l'IA et prendre des décisions informées sur la manière dont ils intègrent cette technologie dans leur processus créatif . Il est également nécessaire de promouvoir la diversité des ensembles de données utilisés pour l'entraînement des algorithmes d'IA, afin d'éviter les biais et de favoriser une représentation plus équilibrée.

En fin de compte, l'IA dans les pratiques artistiques et culturelles offre de nouvelles perspectives et des possibilités d'exploration créative . Cependant, il est important de rester conscient des implications éthiques et de travailler ensemble pour créer un équilibre entre l'innovation technologique et la préservation de l'authenticité artistique.

La collaboration entre l'IA et les artistes peut également donner lieu à des expériences innovantes et participatives. Par exemple, des projets tels que l'art génératif basé sur l'IA permettent au public d'interagir avec des systèmes d'IA pour co-créer des œuvres d'art uniques et personnalisées . Ces expériences mettent en évidence le potentiel de l'IA pour encourager la participation du public et pour repenser les rôles traditionnels de l'artiste et du spectateur.

Les avancées récentes dans le domaine de l'IA artistique ont également suscité des recherches et des études approfondies. Les chercheurs explorent les différentes méthodes d'apprentissage automatique et les modèles génératifs pour comprendre comment l'IA peut être utilisée de manière créative . Ils examinent également les enjeux éthiques et juridiques liés à l'utilisation de l'IA dans la création artistique.

Un exemple notable de recherche dans ce domaine est le projet "DeepArt" . Ce projet explore comment les réseaux neuronaux profonds peuvent être utilisés pour générer des peintures originales en imitant le style d'artistes célèbres. L'algorithme apprend à partir d'une grande base de données d'œuvres d'art et est capable de générer de nouvelles images qui présentent des similitudes frappantes avec les styles des artistes référencés.

En conclusion, l'utilisation de l'IA dans les pratiques artistiques et la production artistique offre de nouvelles opportunités pour les artistes et les créateurs. Cependant, il est essentiel de considérer les implications éthiques, la perte potentielle d'authenticité artistique et les questions de propriété intellectuelle. Les recherches et les études dans ce domaine sont cruciales pour guider l'utilisation de l'IA de manière réfléchie et pour explorer les possibilités créatives offertes par cette technologie émergente.

Dans le domaine du travail intellectuel, l'utilisation de l'IA a également été étudiée dans le contexte de la recherche académique. Les chercheurs explorent comment l'IA peut être utilisée pour faciliter la découverte de connaissances et accélérer le processus de recherche. Par exemple, des techniques d'apprentissage automatique peuvent être appliquées à des ensembles de données volumineux pour identifier des modèles, des tendances et des relations entre les variables, aidant ainsi les chercheurs à formuler de nouvelles hypothèses et à générer des idées novatrices .

Une autre application intéressante de l'IA dans le travail intellectuel est la génération automatique de résumés scientifiques. Les systèmes d'IA peuvent analyser des articles de recherche et extraire les informations clés pour générer des résumés concis et informatifs. Cela peut être particulièrement utile pour les chercheurs qui doivent parcourir une grande quantité de littérature scientifique dans leur domaine .

De plus, l'IA est utilisée dans l'édition et la révision de textes. Les correcteurs orthographiques et grammaticaux basés sur l'IA aident les auteurs et les rédacteurs à détecter et à corriger les erreurs de langue, améliorant ainsi la qualité globale du texte. Des outils avancés utilisant des techniques de traitement du langage naturel peuvent également fournir des suggestions de reformulation, d'amélioration de la structure et de simplification du langage, contribuant ainsi à la clarté et à la compréhension du contenu .

Cependant, il convient de noter que l'utilisation de l'IA dans le travail intellectuel ne remplace pas le rôle des professionnels humains. Les systèmes d'IA peuvent être des outils puissants pour soutenir les tâches cognitives, mais ils ne peuvent pas remplacer la réflexion critique, la créativité et le jugement humain. L'expertise et l'expérience des professionnels restent essentielles pour interpréter les résultats générés par les systèmes d'IA, évaluer leur validité et prendre des décisions éclairées.

En conclusion, l'IA offre des possibilités prometteuses dans le domaine du travail intellectuel, en améliorant l'efficacité et la qualité des processus de traduction, de rédaction, de génération de contenu et de recherche. Cependant, il est important de trouver un équilibre entre l'utilisation de l'IA et l'expertise humaine, afin de garantir des résultats fiables, éthiques et pertinents. Les professionnels du secteur doivent rester informés des dernières avancées technologiques, tout en développant leurs compétences et leur expertise pour tirer pleinement parti des avantages offerts par l'IA.

En outre, l'IA est utilisée dans le domaine de la veille stratégique et de l'analyse de données. Les entreprises et les organisations collectent d'énormes quantités de données provenant de diverses sources, telles que les médias sociaux, les forums en ligne et les bases de données publiques. L'IA permet d'analyser ces données de manière efficace pour détecter des tendances, des opinions et des informations précieuses qui peuvent aider à prendre des décisions stratégiques éclairées .

Dans le domaine de l'éducation, l'IA joue également un rôle croissant. Les systèmes d'IA peuvent être utilisés pour la création de programmes d'apprentissage adaptatifs, qui s'adaptent aux besoins et aux capacités de chaque apprenant. Ces programmes peuvent fournir un soutien personnalisé, des recommandations de contenu et des évaluations adaptées, ce qui peut améliorer l'efficacité et l'efficacité de l'apprentissage .

Cependant, l'utilisation de l'IA dans le domaine du travail intellectuel soulève également des préoccupations. Les questions de confidentialité et de sécurité des données sont essentielles, car de nombreuses informations sensibles peuvent être traitées par les systèmes d'IA. Il est donc important de mettre en place des mécanismes appropriés pour protéger la vie privée des individus et assurer la sécurité des données .

De plus, il est crucial de prendre en compte les biais et les préjugés dans les systèmes d'IA utilisés dans le travail intellectuel. Les algorithmes d'apprentissage automatique peuvent refléter les biais existants présents dans les données d'entraînement, ce qui peut entraîner des résultats discriminatoires ou injustes. Il est donc nécessaire de mettre en place des procédures d'évaluation et de correction pour atténuer ces biais et garantir des résultats équitables et non discriminatoires .

En somme, l'utilisation de l'IA dans le domaine du travail intellectuel offre des avantages significatifs, tels que l'amélioration de la recherche, la génération automatique de résumés, l'édition de textes et l'analyse de données. Cependant, il est essentiel d'aborder les questions de confidentialité, de sécurité des données, de biais et d'éthique pour garantir que l'IA est utilisée de manière responsable et bénéfique. Les chercheurs, les professionnels et les décideurs doivent continuer à collaborer pour développer des normes et des lignes directrices qui encadrent l'utilisation de l'IA dans le travail intellectuel et favorisent des pratiques éthiques et inclusives.

Alors… que faire ?!

D’abord ne pas se crisper et paniquer face à cette révolution en cours. Celle-ci nous échappe sur de nombreux points. Pour faire face à ces défis, des initiatives et des réglementations émergent pour réguler chaque secteur. Par exemple, l’Union européenne a adopté le Règlement sur la gouvernance des données, qui vise à promouvoir l’échange de données entre les entreprises et à renforcer la protection des données des utilisateurs. Des institutions telles que l’IEEE (Institute of Electrical and Electronics Engineers) ont développé des lignes directrices éthiques pour guider le développement et l’utilisation de l’IA de manière responsable. Très bien mais encore… Des chercheurs travaillent sur des approches démocratisantes visant à rendre l’IA accessible à tous et à garantir une diversité d’acteurs dans son développement et son utilisation. L’idée est d’éviter la concentration du pouvoir et de favoriser des applications que l’on pourrait qualifier d’équitables et d’inclusives, plutôt qu’opportunistes et intrusives. Nous conviendrons que toutes ces mesures ou initiatives ne suffiront sûrement pas à amadouer ce nouveau protagoniste. Il est également essentiel d’éduquer et de sensibiliser la population des implications que devraient engendrer l’IA. Les gouvernements, les universités et les organisations à but non lucratif jouent un rôle dans la promotion de la littératie en matière d’IA et dans la préparation des humains aux changements induits par cette technologie. Il ne tient qu’à nous de nous saisir de ces promesses et de nous mobiliser pour prendre et garder notre destin en main….

Pour faire face à ces défis, plusieurs mesures nous semblent indispensables à mettre en place :

-

Transparence : Les entreprises et les gouvernements doivent respecter la législation et être transparents quant à l’utilisation de l’IA dans la surveillance et la sécurité. Les décisions et les politiques concernant l’utilisation de l’IA doivent être clairement communiquées au public, et il convient d’établir des mécanismes de reddition de comptes pour garantir la responsabilité. La transparence implique de divulguer les types d’algorithmes utilisés, les sources de données, les méthodes de collecte et de traitement des données, ainsi que les critères utilisés pour prendre des décisions. Cette transparence permettra aux individus et aux organismes de comprendre comment l’IA est utilisée et de vérifier si elle est utilisée de manière appropriée et éthique.

-

Réglementation & régulation : Des réglementations appropriées doivent être mises en place pour encadrer l’utilisation de l’IA dans la surveillance et la sécurité, ainsi que dans d’autres secteurs. Ces réglementations devraient aborder les questions de confidentialité, de sécurité, de biais et d’éthique, tout en favorisant l’innovation et la protection des droits individuels. Nous ferons un article axé sur ce sujet prochainement.

-

Évaluation d’impacts : Une évaluation d’impacts rigoureuse doit être réalisée pour évaluer les conséquences sur la vie privée, les droits fondamentaux, la sécurité, l’environnement et la démocratie. Il est essentiel de garantir l’indépendance et la transparence de cette évaluation. La réglementation existante, telle que le RGPD et la Directive ePrivacy, peut servir de référence pour encadrer cette démarche. Une formation et une sensibilisation accrues sont nécessaires pour former les utilisateurs, les décideurs et les opérateurs aux enjeux éthiques et responsables de l’IA. La collaboration entre les gouvernements, les entreprises, la société civile et les chercheurs est essentielle pour trouver des solutions équilibrées et favoriser une utilisation responsable de l’IA dans la surveillance et la sécurité, tout en préservant l’environnement et les principes démocratiques.

-

Formation et sensibilisation : Il est nécessaire d’assurer la transparence en communiquant clairement les décisions et politiques liées à l’IA, ainsi que de mettre en place des mécanismes d’audit et de reddition de comptes. Une réglementation adéquate, basée sur des modifications ou compléments aux textes de loi existants, doit encadrer l’utilisation de l’IA, en abordant les questions de confidentialité, de sécurité, de biais et d’éthique. Une évaluation indépendante et transparente de l’impact environnemental, démocratique et des droits fondamentaux doit être réalisée avant le déploiement de systèmes d’IA. Il est crucial de former et sensibiliser les utilisateurs, décideurs et opérateurs sur les enjeux liés à l’IA, afin de promouvoir une utilisation responsable et éthique, tout en évitant les abus et les erreurs. Enfin, une collaboration et un partenariat entre gouvernements, entreprises, société civile et chercheurs sont essentiels pour résoudre les défis liés à l’IA, tout en préservant les droits fondamentaux et en protégeant l’environnement et la démocratie.

-

Collaboration et partenariat : Pour faire face aux défis de l’utilisation de l’IA dans la surveillance et la sécurité, plusieurs mesures essentielles doivent être mises en place. Il est nécessaire d’assurer la transparence de l’utilisation de l’IA et d’établir des mécanismes de reddition de comptes. Des réglementations appropriées doivent encadrer l’utilisation de l’IA, en abordant les questions de confidentialité, de sécurité, de biais et d’éthique. Une évaluation rigoureuse de l’impact de l’IA doit être réalisée avant le déploiement, en prenant en compte la vie privée, les droits fondamentaux et la sécurité. La formation et la sensibilisation des utilisateurs, décideurs et opérateurs sont essentielles pour une utilisation responsable et éthique de l’IA. La collaboration et le partenariat entre les gouvernements, les entreprises, la société civile et les chercheurs sont nécessaires pour résoudre les défis. Enfin, la promotion de la recherche, la gouvernance multipartite et l’implication du public sont des mesures complémentaires pour garantir une utilisation responsable et équitable de l’IA dans la surveillance et la sécurité. Ces mesures peuvent s’appuyer sur des textes de loi existants tels que le RGPD et la Loi pour une République Numérique en France.

-

Instauration d’un Revenu Universel : Dans le contexte de l’automatisation croissante due à l’IA, certains experts suggèrent l’instauration d’un revenu universel pour faire face aux éventuels impacts socio-économiques de la substitution du travail humain par des machines. Un revenu universel garantirait un niveau de vie de base à tous les individus, indépendamment de leur emploi ou de leur participation au marché du travail. Cette mesure permettrait de faire face aux inégalités économiques et de prévenir une éventuelle exclusion sociale résultant de la transformation du marché de l’emploi par l’IA.

En mettant en œuvre ces mesures, il nous serait envisageable de bénéficier des avantages de l’IA dans la surveillance et la sécurité tout en atténuant les risques potentiels de troubles sociétaux. Il devient urgent et crucial de trouver un équilibre entre la protection des droits individuels, la sécurité et l’efficacité opérationnelle, afin de construire un avenir où l’IA sera utilisée de manière responsable et bénéfique pour la société et la planète.